최신연구

[곽수하 교수] Efficient and Versatile Robust Fine-Tuning of Zero-shot Models

[연구의 필요성]

대규모 이미지-텍스트 사전학습 모델은 제로샷 추론 능력을 갖추어 다양한 데이터 분포에서 일정 수준의 성능을 보이나, 하위 작업으로의 전이 과정에서 기존의 전체 파인튜닝 방식은 실제 분포 간 차이가 큰 상황에서 일반화 능력이 크게 저하되며, 막대한 계산 자원과 메모리, 스토리지를 소모하는 한계가 있다. 특히 기존의 파인튜닝 방식들은 목적에 특화된 세부 조정 시 모델이 갖는 사전학습 지식의 활용도를 저해하여, 실제 환경에서의 분포 이동이나 외부 데이터에 대한 적응력이 떨어진다. 이러한 문제점을 해결하기 위해 제로샷 모델의 강점을 유지하면서도, 다운스트림 작업에 적합한 성능 향상 및 분포 변화에 대한 견고함(OOD Robustness)을 확보하는 효율적이고 경량화된 파인튜닝 방법론의 필요성이 대두된다.

[포스텍이 가진 고유의 기술]

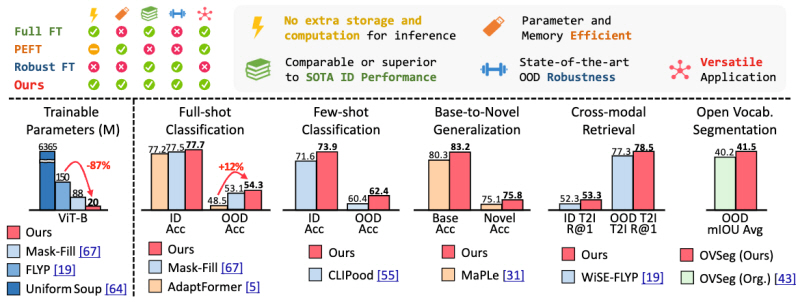

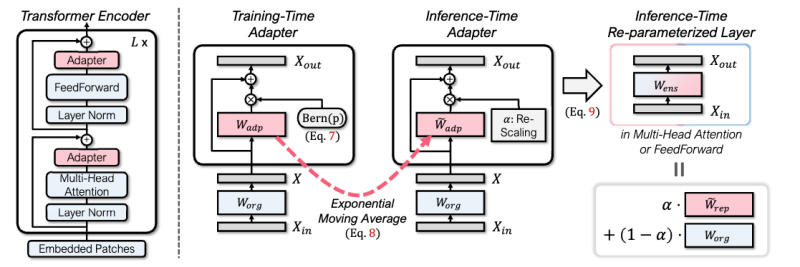

본 연구는 파인튜닝 과정에서 전체 모델의 업데이트 없이 일부 경량 모듈만을 학습하는 Parameter-Efficient Fine-Tuning(PEFT)의 장점을 극대화하고, 동시에 Robust Fine-Tuning에서 요구되는 분포 변화에 대한 내성을 강화하기 위해 ‘Robust Adapter (R-Adapter)’를 제안한다. 이 방법은 모델 내에 어댑터 모듈을 추가하고, 어댑터 드롭 (Adapter Dropping), 어댑터 가중치 누적 (Accumulation), 가중치 재조정 (Re-scaling)의 세 가지 자가 앙상블 전략을 도입하여, 사전학습 모델과 파인튜닝된 모듈 간의 최적의 결합 효과를 구현하며, 추가적인 저장 및 계산 비용 없이 효율적으로 성능을 향상시키도록 설계된다. 또한, 다중 양성 샘플 간 정밀 정렬을 도모하는 MPM-NCE 손실 함수를 도입함으로써, 이미지와 텍스트 간의 미세한 대응 관계를 효과적으로 학습하는 기술을 선보인다.

본 연구는 데이터의 복잡하고 다양한 계층 구조를 직접적인 주석 정보 없이 파악하고, 해당 구조를 임베딩 공간 내에 효과적으로 반영하는 것을 목표로 한다. 이를 위해, 본 연구에서는 데이터들을 계층적으로 군집화 할 수 있는 새로운 기법인 HIER를 제안한다. 구체적으로, 제안하는 방법은 데이터들의 상위 계층을 나타내는 매개변수인 계층적 프록시 (hierarchical proxy)를 도입함으로써, 프록시와 데이터 간의 계층적 상하 관계를 학습한다. 특히, 계층 구조를 표현하는 데에 적합한 특성을 가진 쌍곡선 공간 (Hyperbolic space)을 활용하여, 데이터의 의미론적 계층 구조를 정교하게 근사하는 방법을 제안한다.

[연구의 의미]

본 연구는 데이터의 의미적 계층 구조를 주석 없이 자기 지도적으로 파악하고, 이를 활용하여 데이터의 실제 유사성을 보다 정확히 반영할 수 있는 임베딩 공간을 학습하는 방법을 새롭게 제안했다는 점에서 큰 의미를 가진다. 이를 통해 기존의 척도 학습 방법들이 가지고 있는 한계를 극복함으로써, 이미지 검색, 얼굴 인식, 사람 식별 등 다양한 응용 분야에서의 성능 향상을 기대할 수 있다.

[연구결과의 진행 상태 및 향후 계획]

본 연구는 2024년 컴퓨터비전 분야 최우수 국제학술대회 중 하나인 The European Conference on Computer Vision (ECCV)에서 소개되었다. 현재는 다양한 이기종 데이터들이 섞여 있을 수 있는 실제 시나리오에서의 척도 학습 문제에 대한 연구를 진행중이다.

[성과와 관련된 실적]

Sungyeon Kim, Boseung Jeong, Donghyun Kim, Suha Kwak, “Efficient and Versatile Robust Fine-Tuning of Zero-shot Models”, ECCV 2024

[성과와 관련된 이미지]