최신연구

[유환조 교수] Distillation from Heterogeneous Models for Top-K Recommendation

[연구의 필요성]

최근 추천 시스템의 정확성(accuracy)은 빠른 속도로 발전해온 반면, 효율성(efficiency) 문제는 지속해서 증가하고 있으며 그 중요도에 비해 많은 연구가 이루어지지 않았다. 방대한 양의 파라미터를 갖는 거대 추천 모델은 우수한 표현 능력을 통해 사용자의 복잡한 선호 정보를 정확하게 포착할 수 있으며, 이로 인해 높은 추천 정확도를 갖는다. 그러나, 이러한 거대 모델은 아이템 추천을 위해 높은 계산 비용과 긴 지연시간(Latency)을 발생시키며, 낮은 효율성으로 인해 실시간 서비스에서 활용되기 어렵다는 한계를 갖는다. 대규모 추천 모델의 효율성 문제에 대한 해답으로, 추천 성능을 유지하면서 모델의 크기를 축소하는 지식 증류 기법의 필요성이 대두되었다. 이러한 문제를 해결하고자, 본 연구에서는 성공적인 추천 시스템을 위한 2가지의 필요조건—정확성, 효율성—을 갖춘 모델 생성을 위한 지식 증류 기술을 개발하는 것을 목표로 한다. 구체적으로, 이종(heteorogeneous) 추천 모델들의 예측을 종합한 앙상블 지식을 지식 증류 기법을 통해 단일 모델에 전달하여, 거대 추천 시스템의 정확도를 재현하면서도 짧은 지연시간을 갖는 모델을 생성한다.

[포스텍이 가진 고유의 기술]

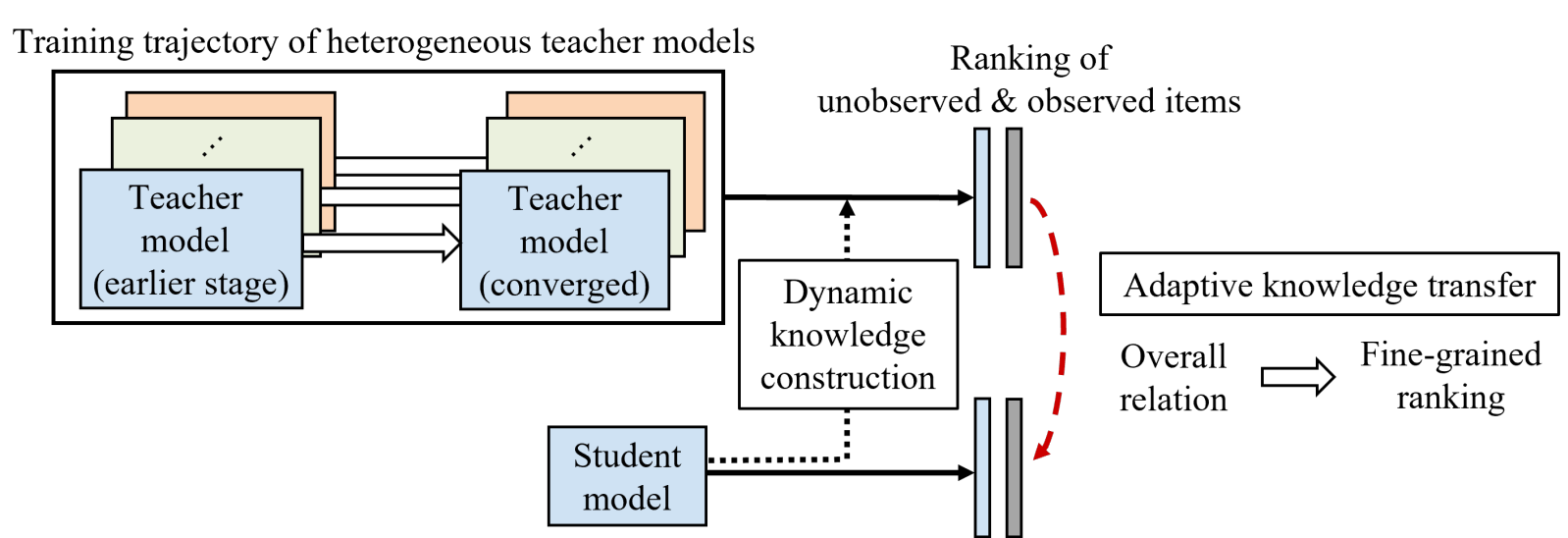

본 연구에서는 먼저 기존 지식 증류 기법들이 이종 모델의 지식을 효과적으로 전달하지 못한다는 것을 보여주는 상세한 분석을 제시한다. 나아가, 랭킹 모델이 학습과정에서 점진적으로 어려운 지식을 학습함을 보여주는 실험적 발견을 제시한다. 이후, 상이한 귀납적 편향을 갖는 지식을 효과적으로 증류하기 위한 HetComp 기법을 제안한다. 본 연구에서는 점진적 난이도 증가 학습의 개념을 차용한다. 이는 인간의 학습 과정에서 영감을 받아 더 쉬운 지식을 먼저 학습한 다음 점차 더 복잡한 지식을 학습하는 방법론으로, 기계 학습의 다양한 분야에서 광범위하게 연구되어왔다. HetComp는 (1) 점진적 지식 구성 기법, (2) 점진적 랭킹 지식 증류 기법으로 구성된다.

[연구의 의미]

본 연구는 추천시스템 분야에서 아래와 같은 의미를 갖는다.

(1) 분석 제시: 그동안 연구되어오지 않았던 이종 추천 모델 증류의 필요성 및 기존 기법들의 한계를 보여주는 상세한 분석을 제공한다.

(2) 추천 정확성 및 효율성 개선: 이종 추천 모델들의 앙상블로 구성되는 거대 추천 시스템을 압축하여, 거대 추천 시스템의 정확도를 유지하면서 예측 소요 시간을 크게 단축한다.

(3) 유연한 확장성: 제안하는 기법은 모델의 연관 점수 표현 방식 등과 무관하게 동작하며, 추후 개발되는 모든 형태의 추천 모델로 확장될 수 있다.

[연구결과의 진행 상태 및 향후 계획]

유저-아이템 데이터가 실시간으로 수집되는 시스템에서 모델 학습, 지식 증류로 이원화된 기존의 학습 패러다임을 최적화하는 방향으로 후속 연구를 진행 중이다.

[성과와 관련된 실적]

– SeongKu Kang, Wonbin Kweon, Dongha Lee, Jianxun Lian, Xing Xie, Hwanjo Yu. 2023. Distillation from Heterogeneous Models for Top-K Recommendation. In Proceedings of the ACM Web Conference 2023 (WWW’23)

[성과와 관련된 이미지]