최신연구

[황인석 교수] 인간 대상 AI 모델의 강건성 강화를 위한 능동적 액츄에이션 방법

[연구의 필요성]

현재까지 인간의 감정, 인간의 활동 등 인간에 관한 다양한 정보를 추론하는 AI 모델이 개발되어왔다. 이러한 AI 모델이 실험실 환경을 떠나 실생활에 적용되면, 실생활 환경의 다양성으로 인해 추론 성능이 하락하는 순간을 필연적으로 만나게 된다. 예를 들어, 비전 기반 AI 모델에서 대상 인간의 얼굴이 정면이 아닌 옆면 혹은 뒷면만 보이거나, 대상 인간이 장애물에 가려져 있는 상황은 추론에 활용할 수 있는 정보가 매우 제한적이다. 종래 연구에서는 이와 같은 상황에서의 강건성을 확보하기 위해 새로운 데이터셋을 구축하고 모델의 복잡성을 증대하는 등 시간적 및 경제적 비용을 발생시키는 단점을 갖고 있다. 또한 대비하였던 상황의 분포에서 벗어난 상황이 발생하는 경우, AI 모델이 인간을 추론하기 쉬운 상황이 될 때까지 무한정 기다려야 하는 한계를 갖는다. 본 연구에서는 인간의 능동성을 활용하여, 종래 연구의 비용과 한계를 동반하지 않으면서 AI 모델의 강건성을 확보하는 방법을 제안한다.

[포스텍이 가진 고유의 기술]

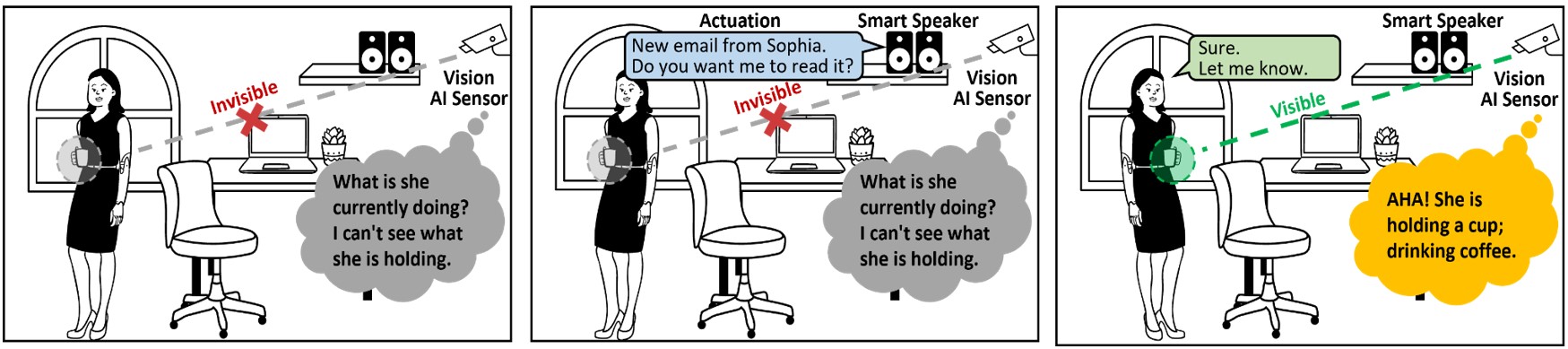

본 연구에서는 우리 일상 공간에 이미 널리 존재하는 다양한 스마트 디바이스(대화형 디스플레이, 스마트 스피커 등)의 동작(디스플레이 컨텐츠 변화, 대화 개시 등)를 활용하여, 대상 인간을 AI가 추론하기 어려운 조건에서 추론하기 쉬운 조건으로 유도하는 능동적 액츄에이션 방법을 최초로 제안한다.

예를 들어, 얼굴을 통해 감정을 추론하는 AI 모델에서 대상 인간의 얼굴의 옆면 혹은 뒷면만 확인할 수 있는 상황일 때, 대상 인간 주변의 스마트 스피커가 대화를 개시하면, 인간은 스피커를 향해 얼굴을 틀게 되어 AI 모델이 정면 얼굴을 포착하도록 상황을 변화시킬 수 있다. 또는 전신 이미지를 통해 인간의 자세를 추정하는 모델에서 대상 인간이 너무 가까이 있거나 멀리 있는 경우, 거리를 기반으로 동작하는 디스플레이의 컨텐츠를 변화시켜, 대상 인간이 디스플레이와 인터랙션하면서 AI 모델이 대상 인간의 다양한 거리에서의 전신 이미지를 확보할 수 있도록 도울 수 있다.

위의 두 예는 능동적 액츄에이션이 구현된 일부 예이며, 본 연구에서 제안한 방법론은 유비쿼터스 컴퓨팅 분야의 다양한 스마트 디바이스의 포괄적 협력, 능동적 동작, 그리고 다양한 인간 대상 AI 모델로 확장된다.

[연구의 의미]

본 연구에서는 AI의 실제 환경하 강건성 재고를 위한 전례 없던 전략으로서 능동적 액츄에이션 기법을 최초로 제안하였으며, 방법론의 효과성과 사용자 경험을 검증하기 위한 실제 환경하 실험을 설계하고 수행하였다. 검증 결과를 바탕으로, 본 방법론을 실생활에 적용할 수 있는 현실성 강화를 위해 다양한 실질적 관점(액츄에이션에 대한 인간의 반응도, 액츄에이션에 의한 성능 향상이 발생하기까지의 시간, AI 모델이 추론하는 정보의 변화도 등)을 탐색하고 가이드라인을 제시하였다.

본 연구의 방법론은 종래 연구와 달리 높은 계산적, 경제적 비용을 요구하지 않으면서, 스마트 디바이스의 풍부한 동작을 활용하여 AI 모델의 추론하기 어려운 상황에 보다 유연하게 대처할 수 있을 것이다.

[연구결과의 진행 상태 및 향후 계획]

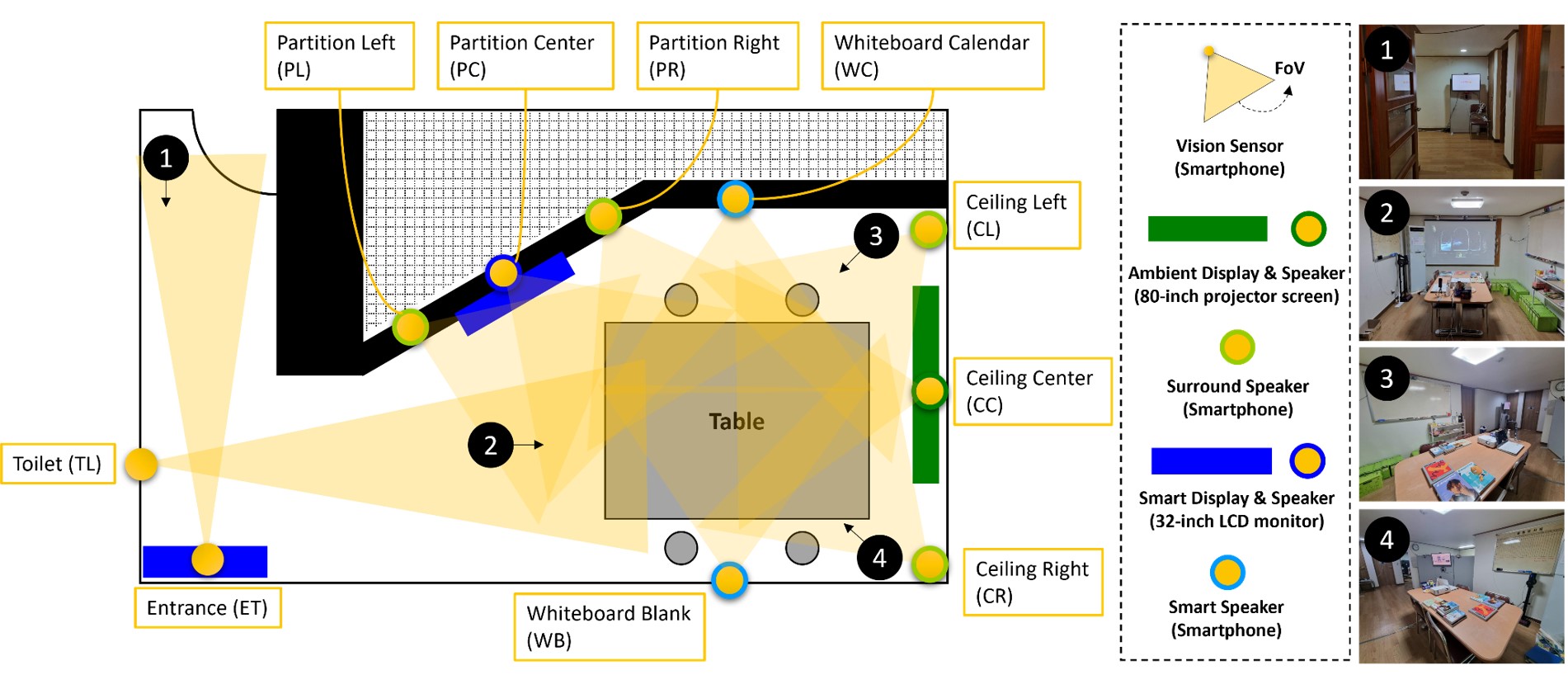

본 연구의 실험은 방법론의 초기 검증을 위해 한 사람이 스마트홈 공간에 있는 상황에서 진행하였다. 이와 다르게 여러 사람이 생활하는 공용 공간의 상황에서 실험을 진행하여 다양한 상황에서 방법론을 추가로 검증할 것이다. 또한 인간 대상 AI 모델의 어려운 상황을 감지하고, 기존재하는 스마트 디바이스의 동작을 활용하는 자동화 시스템을 개발하고자 한다.

[성과와 관련된 실적]

* 국제 학술대회 논문:

– 실제 환경에 적용된 AI의 실질적 성능 향상을 추구하는 전략은 여러 종류가 있었으나, 본 연구의 인간대상 액츄에이션 기법은 전례 없었던 새로운 축의 시도로서 그 참신성을 인정받았고, 더불어 실제적 환경 하에서의 AI 성능 향상에 대한 효과성도 인정받아, HCI 및 유비쿼터스 컴퓨팅 분야 최우수 국제학술대회인 ACM UbiComp 2023에 논문이 게재 수락 되었음.

– Sungjae Cho, Yoonsu Kim, Jaewoong Jang, Inseok Hwang. AI-to-Human Actuation: Boosting Unmodified AI’s Robustness by Proactively Inducing Favorable Human Sensing Conditions. ACM UbiComp 2023. (Also published in ACM IMWUT (Proceedings of the ACM on Interactive, Mobile, Wearable and Ubiquitous Technologies).

[성과와 관련된 이미지]

그림 1. 능동적 액츄에이션의 사례: (1) 대상 인간의 신체 방향으로 인하여 AI 모델이 현재 인간의 활동을 추론하기 어렵다. (2) 주변의 스마트 스피커가 대상 인간에게 대화를 개시한다 (액츄에이션) (3) 대상 인간의 신체 방향이 변화되고 AI 모델이 현재 인간의 활동을 추론할 수 있게 된다.

그림 2. 본 연구에서 제안한 방법론을 검증하기 위해 구현한 실험 환경