최신연구

[이남훈 교수] ZIP: An Efficient Zeroth-order Prompt Tuning for Black-box Vision-Language Models

[연구의 필요성]

최근 ChatGPT, Gemini 등 대부분의 상업용 AI 모델은 내부 파라미터에 대한 직접적인 접근이 불가능한, 이른바 블랙박스(Black-box) 형태로 제공되는 경우가 많다. 이러한 환경에서는 모델의 파라미터를 수정하지 않고도 원하는 성능을 얻기 위한 ‘블랙박스 트레이닝(Black-box Training)’ 기법에 대한 관심이 시대의 변화에 따라 점차 높아지고 있다. 블랙박스 트레이닝은 주로 영차 최적화(Zeroth-order Optimization)나 강화학습(Reinforcement Learning)에 기반하지만, 이들 방법은 일반적으로 수렴 속도가 느리다는 한계를 갖는다. 수렴 속도는 곧 모델에 대한 쿼리, 즉 API 호출 횟수와 밀접하게 연결되어 있어, 훈련 비용 문제로 직결된다. 본 연구는 이러한 문제의식에 기반하여, 영차 최적화를 활용한 블랙박스 트레이닝 환경에서 수렴 속도를 향상시킬 수 있는 새로운 알고리즘을 제안한다.

[포스텍이 가진 고유의 기술]

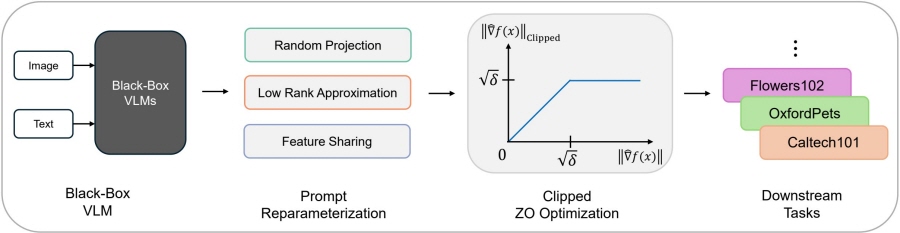

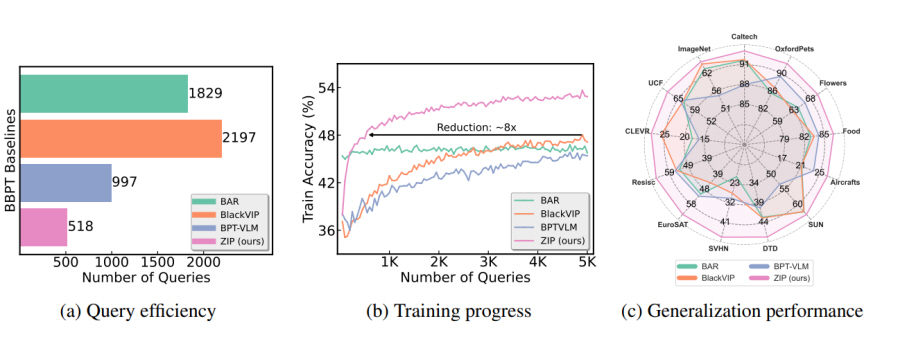

본 연구에서는 영차 최적화의 수렴 속도가 모델 파라미터의 개수에 비례한다는 사실을 이론적 분석과 실험을 통해 확인하였다. 이를 바탕으로, soft prompt의 파라미터 수를 효과적으로 줄일 수 있는 내재적 차원 감소 기법을 제안하였다. 제안한 방법은 최적화해야 할 파라미터의 수를 크게 줄이면서도, feature sharing 기법과 내재적 차원의 구조적 특성을 활용함으로써 성능 저하 없이 효과적인 최적화를 가능하게 한다. 본 연구에서는 영차 최적화 기법의 느린 수렴 속도가 추정 기울기의 높은 분산에서 비롯된다는 점을 지적하고, 이를 완화하기 위한 방안으로 gradient clipping 기법을 도입하였다. 특히 gradient clipping에서는 임계값(threshold)의 설정이 성능에 중요한 영향을 미치는데, 본 연구는 영차 최적화 및 clipping과 관련된 이론적 분석을 바탕으로 최적화된 threshold 선택 방법을 제안하였다. 제안된 방식은 실제 실험을 통해 최적값(optimal)에 근접한 성능을 달성함을 확인하였다.

[연구의 의미]

본 연구는 기존에 경시되고 있던 Black box training에서의 API query cost에 대한 문제를 지적했다는 점 뿐만 아니라, 해당 문제를 이론적 기반을 둔 여러 technique을 통해 매우 효과적으로 풀어냈다는 점에서 의미를 가진다. 이와 같은 접근은 블랙박스 환경에서의 효율적인 학습 방법을 제시함으로써, API 기반 상용 모델을 활용한 downstream task 최적화의 실용성과 효율성을 동시에 향상시킬 수 있는 기반을 마련하였다는 점에서 학술적·실용적 기여가 크다.

[연구결과의 진행 상태 및 향후 계획]

본 연구는 인공지능 분야 최우수 국제 학술 대회인 International Conference on Learning Representation (ICLR 2025) 논문으로 채택되어 포스터로 발표될 예정이다. 향후 연구에서는 좀 더 일반화된 시나리오에서 실제로 상업용 인공지능 모델에 바로 적용될 수 있는 방법을 고안하는 것을 목표로 한다.

[성과와 관련된 실적]

Seonghwan Park, Jaehyeon Jeong, Yongjun Kim, Jaeho Lee, Namhoon Lee. “ZIP: An Efficient Zeroth-order Prompt Tuning for Black-box Vision-Language Models”, International Conference on Learning Representations (ICLR), 2025.

[성과와 관련된 이미지]