최신연구

[이남훈 교수] The Effects of Overparameterization on Sharpness-aware Minimization: An Empirical and Theoretical Analysis

[연구의 필요성]

과모수화된 신경망 (overparameterized neural network)을 학습시키는 것은 학습 손실 (training loss)은 같지만 일반화 성능은 다른 여러 개의 최소점을 만들어낸다. 최소점의 첨예도 (sharpness)와 일반화 오차 (generalization error) 간에 상관관계가 있다는 증거가 늘어나면서, 더 일반화가 잘 되는 솔루션을 위해 평탄한 최소점을 찾기 위한 최적화 방법들이 개발되어 왔다. 하지만, 과모수화가 이러한 첨예도 인식 최소화 (sharpness-aware minimization; SAM)에 미치는 영향에 대해서는 아직 많은 연구가 이루어지지 않은 상태이다.\

[포스텍이 가진 고유의 기술]

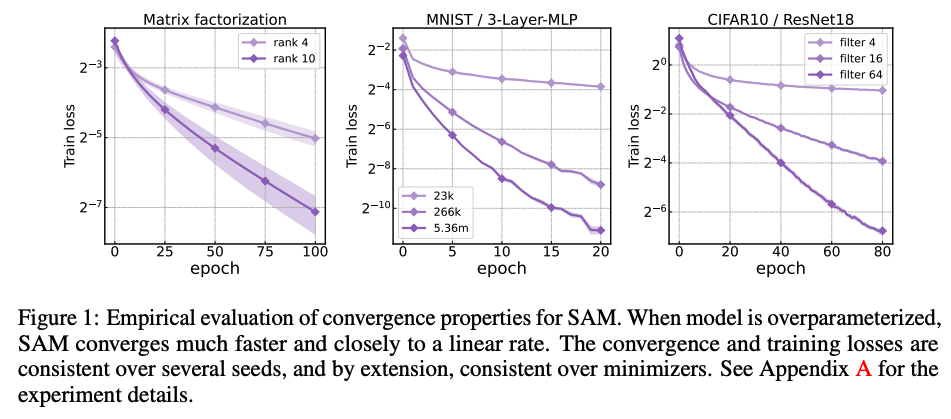

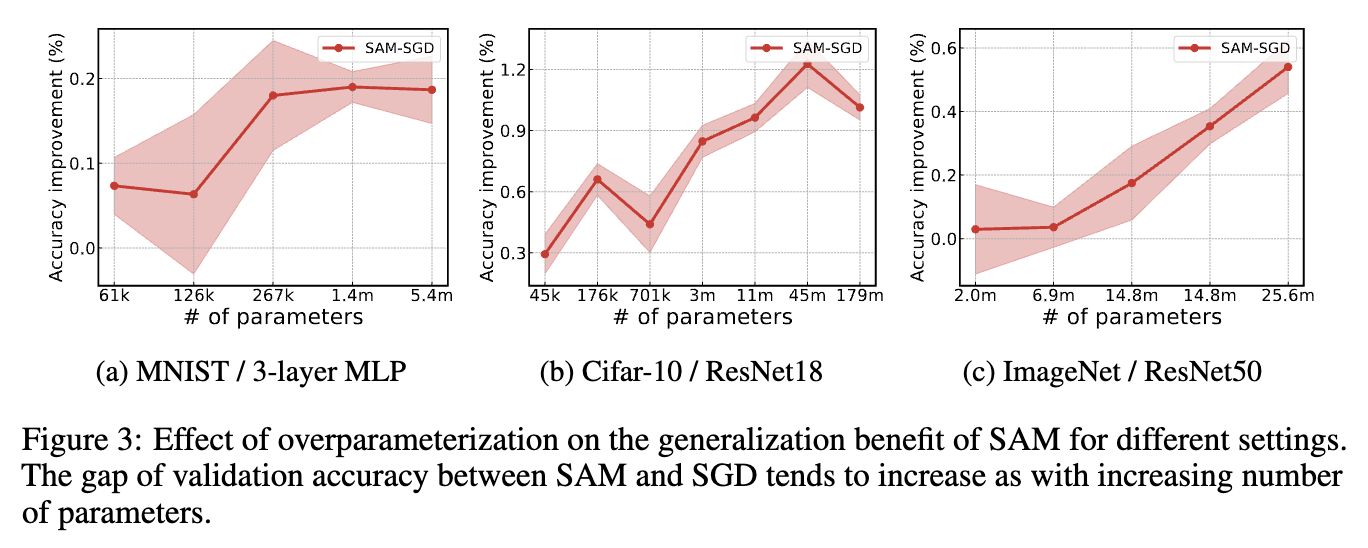

본 연구에서는 과모수화가 SAM에 중대한 영향을 끼치는 것을 경험적,이론적으로 분석하여 다음의 사실을 밝혀내었다. 1) 확률적 SAM이 과모수화 하에서는 선형 수렴 속도를 얻는다. 2) SAM의 선형 안정적인 최소점이 SGD에 비해 더 평탄하면서 균일하게 분포된 헤세 행렬 모멘트를 가진다. 3) 매개변수 수가 늘어남에 따라 SAM의 일반화 성능 향상폭이 늘어난다. 4) 같은 수의 매개변수를 가진 모델 중 밀접한 (dense) 모델에 비해 희박한 (sparse) 모델에서 SAM의 일반화 성능 향상폭이 더 커진다.

[연구의 의미]

본 연구는 수렴 속도, 일반화 성능 등의 여러 측면에서 SAM이 과모수화된 모델을 학습시킬 때 가지는 여러 이점을 보여준다. 이는 현재 트렌드인 대규모/효율적 학습 환경에서 SAM이 지니고 있는 큰 잠재력을 보여주며 실제로 현업에서 대규모 모델을 학습시킬 때 SAM을 쓰는 것을 적극 고려해볼 수 있음을 시사한다.

[연구결과의 진행 상태 및 향후 계획]

다른 첨예도 최소화 기법에 대해 분석을 확장하거나 다른 모델 압축 기법과 SAM의 상관관계에 대해서 분석하는 등으로 연구를 확장하는 것을 계획하고 있다.

[성과와 관련된 실적]

2023 한국인공지능학회 추계학술대회 최우수논문상 수상

[성과와 관련된 이미지]