최신연구

[이근배/옥정슬 교수] Key-Element-Informed sLLM Tuning for Document Summarization

[연구의 필요성]

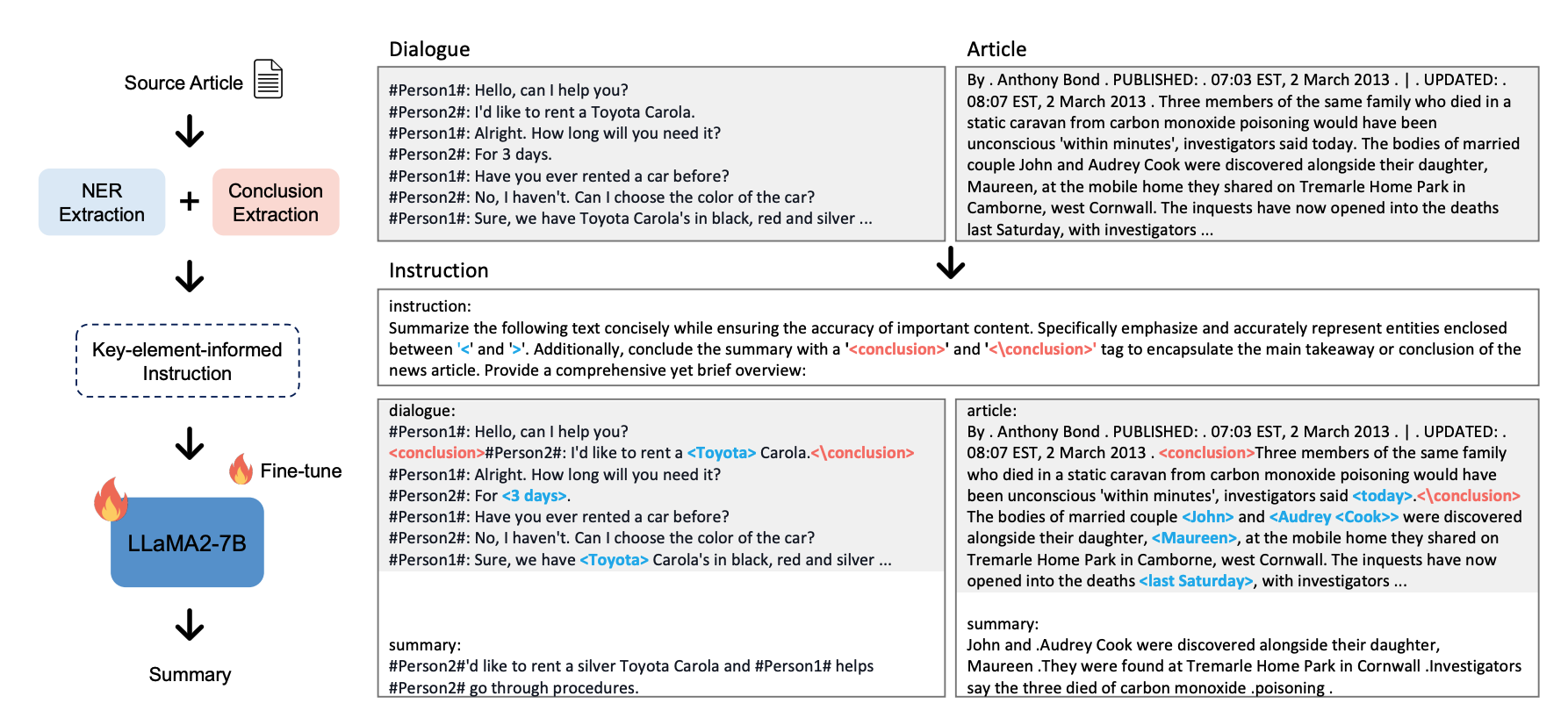

최근 GPT의 발전에 따라, 요약 태스크에서도 LLM이 좋은 성능을 보이고 있다. 하지만, 성능이 좋은 GPT의 경우, 비용과 모델의 크기가 클 뿐아니라, 모델이 공개 되어있지 않기에, 활용에 한계가 있다. 하지만 오픈 소스 LLM들의 경우 본문의 중요한 내용을 잘 포함하지 못하는 문제가 있다. 우리는 NER 모델을 사용하여 본문의 named entity에 강조 토큰을 추가하여, instruction을 구성한 후, 모델이 중요 element들을 요약문에 포함할 수 있도록 instruction-tuning을 하여, 기존 sLLM이 요약태스크에서 가지고 있던 문제점을 해결한다.

[포스텍이 가진 고유의 기술]

우리는 뉴스 요약문에 필요한 element들을 추출하기 위해서 NER과 extractive summarization을 활용한다. NER 모델로 본문과 요약문의 entity들을 추출한 후, 정답 요약문에 어떤 entity가 주로 포함되는 지 비율을 파악한다. 포함 비율이 높은 entity들을 강조 토큰을 통해 prompt에 표시한다. 또한 중요 맥락을 파악하기 위해서 extractive summarization 모델로 본문의 가장 중요한 문장을 추출한 후, 별도의 강조 토큰을 추가한다. 각 강조 토큰에 대한 description을 본문과 함께 추가하여 전체 instruction을 구성한 후, LoRA를 통해 instruction-tuning을 진행한다.

[연구의 의미]

기존에 본문의 중요한 element들을 요약문에 잘 포함시키지 못했던 sLLM의 문제점을 해소하기 위해 element 강조 토큰을 추가한 instruction을 통해 tuning한다. 또한, 본문의 길이 별 분석을 통해, 본문의 길이가 길수록 key element들을 포함시키도록 도와주는 것을 보인다.

[연구결과의 진행 상태 및 향후 계획]

본 연구는 INTERSPEECH 2024에서 발표될 예정이며, 향후 Large Language Model 로의 확장을 계획 중에 있습니다.

[성과와 관련된 실적]

Sangwon Ryu*, Heejin Do*, Yunsu Kim, Gary Geunbae Lee, Jungseul Ok, “Key-Element-Informed sLLM Tuning for Document Summarization**”, INTERSPEECH** 2024

[성과와 관련된 이미지]