최신연구

[이근배 교수] Optimizing Two-Pass Cross-Lingual Transfer Learning: Phoneme Recognition and Phoneme to Grapheme Translation

[연구의 필요성]

세계에는 수 많은 언어가 있지만, 대부분의 언어 기술 개발은 소수의 널리 사용되는 언어에 집중되어 있습니다. 저자원 언어 (low resource languages) 연구는 모든 언어 사용자에게 언어 기술의 혜택을 제공하는 것을 목표로 합니다. 저자원 언어에서의 음성인식 성능을 향상시키기 위해서 음성 데이터외의 텍스트 데이터를 활용할 수 있는 방법과 언어간 정보 교환 방법을 제시합니다. 또한 저자원 언어를 지원하는 기술을 개발함으로써, 보건, 교육, 법률 지원 등과 같은 다양한 자연어처리 서비스를 사용자의 모국어로 제공할 수 있습니다.

[연구의 의미]

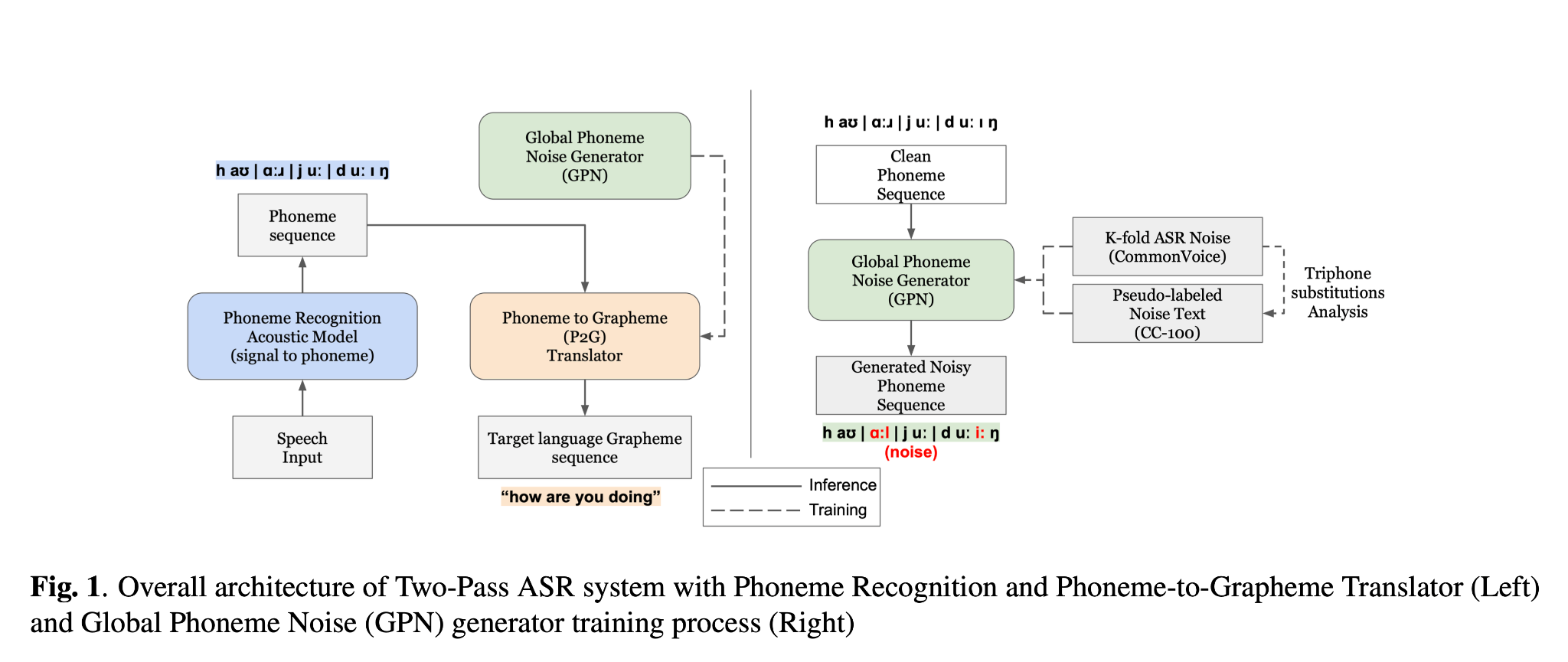

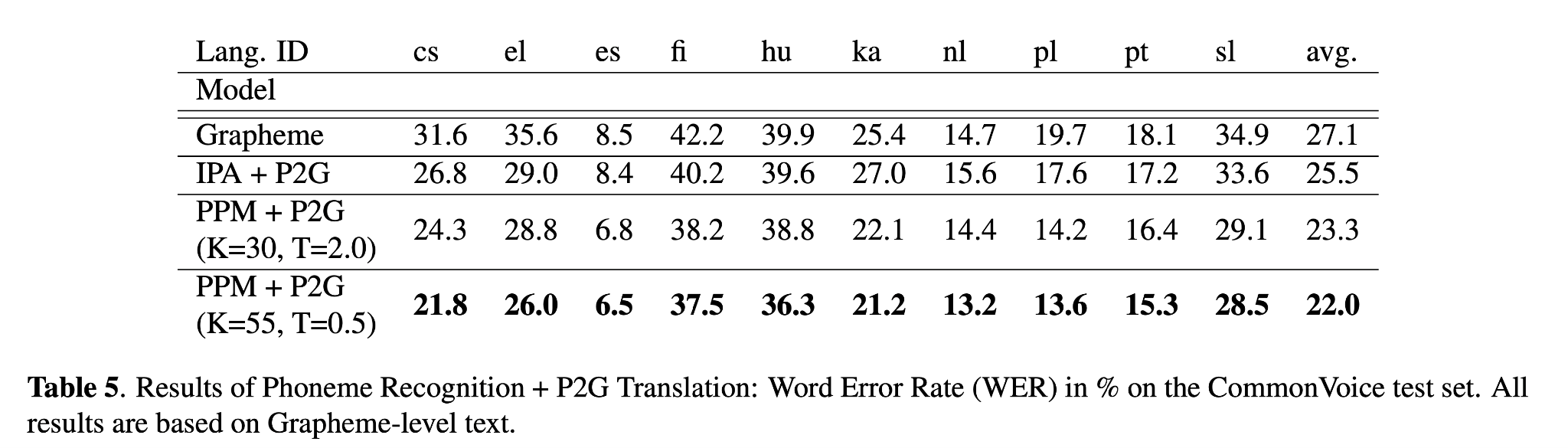

이 연구는 음성 인식(ASR)과 같은 언어 기술을 저자원 언어로 확장하는 데 중요한 기여를 합니다. 사용자의 발화를 음성기호를 먼저 인식한 후, 기계 번역 기술을 활용하여 언어별 텍스트로 변환하는 방법을 채택하여 언어간 음성의 특성을 더욱 잘 공유할 수 있습니다. 음성기호를 언어별 텍스트로 번역하는 과정에 다량의 텍스트 데이터를 활용하여 사전학습을 진행할 수 습니다. 또한 이러한 음성인식 과정을 최적화 할 수 있는 다양한 방법론을 제시합니다. 이를 통해 널리 사용되지 않는 언어들도 기술의 혜택을 받을 수 있게 됩니다.

[연구결과의 진행 상태 및 향후 계획]

10개 국어의 음성인식을 지원하는 현 연구를 바탕으로 추가적인 데이터 확보 및 활용을 통해 인식 가능한 언어의 수를 늘리며 동시에 언어 간의 정보 공유를 극대화하여 기존 언어에서의 음성인식 성능 또한 향상시킬 계획입니다.

[성과와 관련된 실적]

Accepted, IEEE Workshop on Automatic Speech Recognition and Understanding, 2023

[성과와 관련된 이미지]