최신연구

[이근배/옥정슬 교수] DyPCL: Dynamic Phoneme-level Contrastive Learning for Dysarthric Speech Recognition

[연구의 필요성]

현재의 난청 또는 발음 장애(Dysarthria)를 가진 환자들의 음성 인식(DSR, Dysarthric Speech Recognition) 은 일반적인 자동 음성 인식(ASR, Automatic Speech Recognition)에 비해 정확도가 현저히 떨어집니다. 이는 발음의 명확성이 낮고, 발음 방식이 사람마다 다르게 나타나기 때문입니다. 기존 연구들은 데이터 증강(Data Augmentation)과 화자 적응 모델(Speaker Adaptive Training)을 사용해 문제를 해결하려 했지만, 추가적인 데이터나 외부 모델이 필요하여 실용성이 떨어졌습니다.

본 연구에서는 대조 학습(Contrastive Learning, CL)을 활용하여 다양한 발음 패턴에도 불구하고 공통적인 음소(Phoneme)를 인식할 수 있도록 학습하는 방법을 제안합니다. 특히, 기존 연구들이 문장 또는 단어 수준에서 음성을 분석한 것과 달리, 본 연구에서는 음소(Phoneme) 수준에서의 대조 학습(Phoneme-level Contrastive Learning, PCL) 을 적용하여 보다 세밀한 발음 차이를 구별하고자 합니다.

[포스텍이 가진 고유의 기술]

Dynamic Phoneme-level Contrastive Learning (DyPCL) 기법

기존의 단어 수준(word-level) 대조 학습 대신 음소 수준(phoneme-level)에서 대조 학습을 수행하여 발음이 다른 화자 간의 차이를 효과적으로 줄입니다.

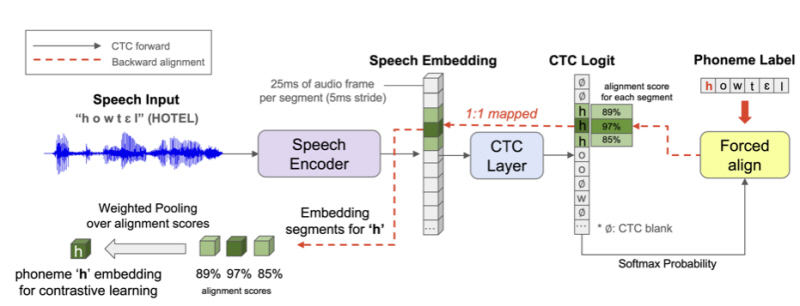

일반적인 대조 학습은 고정된 음소 정렬 방식을 사용하지만, DyPCL은 Dynamic CTC Alignment(동적 CTC 정렬) 을 적용하여 음소 정렬을 학습 과정에서 실시간으로 조정합니다.

Dynamic CTC Alignment

기존 강제 정렬(Forced Alignment) 방식은 일반적인 음성을 기준으로 학습되었기 때문에 난청 환자의 음성을 제대로 정렬하지 못하는 문제가 있었습니다.

본 연구에서는 CTC 모델의 출력을 실시간으로 정렬하여 보다 정확한 음소별 표현을 추출할 수 있도록 개선했습니다.

Dynamic Curriculum Learning (동적 커리큘럼 학습)

음소 간의 유사도를 측정하여 학습 난이도를 조절하는 음소 기반(Phoneme-based) 커리큘럼 학습 기법을 적용했습니다.

초기에 비교적 쉬운 음소 구별을 학습한 후, 점진적으로 구별하기 어려운 음소를 학습하도록 설계하여 모델이 보다 정교한 패턴을 학습할 수 있도록 했습니다.

[연구의 의미]

본 연구는 난청 및 발음 장애 환자의 음성 인식 성능을 획기적으로 향상시키는 새로운 접근법을 제안합니다. 기존의 단어 수준 모델들이 충분한 성능을 보이지 못했던 반면, DyPCL 기법은 음소 수준에서 보다 미세한 차이를 학습할 수 있도록 설계되어 기존 모델 대비 22.10%의 단어 오류율(WER) 감소 효과를 달성했습니다.

특히, 본 연구는 추가적인 데이터 증강이나 외부 모델에 의존하지 않고도 하나의 ASR 모델만으로 학습이 가능하도록 설계되었으며, 이를 통해 실용성을 극대화했습니다. 더 나아가, 난청 화자의 음성을 보다 명확하게 인식할 수 있도록 보조하는 인공지능 기반 음성 인터페이스 개발에 중요한 기여를 할 수 있을 것으로 기대됩니다.

[연구결과의 진행 상태 및 향후 계획]

현재 본 연구는 UASpeech 데이터셋을 활용하여 DyPCL의 성능을 검증하였으며, 실험 결과 기존 모델 대비 전반적인 성능 향상을 확인하였습니다.

특히, 매우 낮은 명료도(Very Low, VL) 그룹에서 단어 오류율(WER)을 58.49%에서 49.45%로 감소시키는 성과를 거두었습니다.

DyPCL이 다양한 환경에서도 일관된 성능을 유지할 수 있도록, 다른 난청 음성 데이터셋(UASpeech 외 다양한 데이터셋)에서 추가 실험을 진행할 예정입니다.

[성과와 관련된 실적]

Wonjun Lee, Solee Im, Heejin Do, Yunsu Kim, Jungseul Ok, Gary Geunbae Lee, NAACL 2025 main conference

[성과와 관련된 이미지]