최신연구

[곽수하 교수] Decoupled Finetuning for Domain Generalizable Semantic Segmentation

[연구의 필요성]

오늘날 인공지능 기술은 이미지 분류, 자연어 처리, 음성 인식, 자율주행 등 다양한 응용 분야에서 인간을 능가하거나 이에 필적하는 수준의 성능을 보이고 있다. 그러나 이러한 높은 성능은 주로 훈련 데이터와 유사한 분포를 가진 테스트 데이터에 국한된 경우가 많다. 즉, 인공지능 모델이 학습에 사용된 데이터에 과적합(overfitting)된 결과, 처음 접하는 낯선 데이터나 훈련 분포와는 다른 실제 환경의 데이터에 대해서는 기대 이하의 성능을 보이는 경우가 빈번하게 발생한다. 이러한 일반화 성능의 부족은 인공지능 시스템의 신뢰성을 크게 떨어뜨리는 요인으로 작용하며, 특히 안전이나 정밀성이 중요한 의료, 금융, 자율주행과 같은 분야에서는 현실 적용에 큰 장애물이 된다. 따라서 인공지능 모델이 다양한 환경에서도 안정적이고 일관된 성능을 발휘할 수 있도록 일반화 능력을 향상시키는 것이 필요하다.

[포스텍이 가진 고유의 기술]

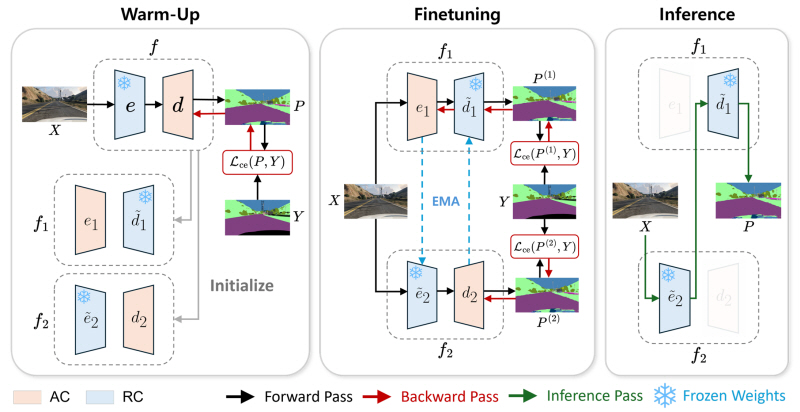

본 연구에서는 현재 인공지능 모델의 학습 과정에서 일반적으로 채택되고 있는 인코더와 디코더 간의 공동 최적화(joint optimization), 즉 두 구성 요소를 하나의 공동 목적 함수 하에 동시에 최적화하는 방식이 모델의 일반화 성능에 있어서 잠재적인 취약점을 가질 수 있음을 이론적 및 실험적으로 분석하였다. 이러한 문제를 극복하기 위해, 본 연구에서는 인코더와 디코더를 분리하여 각 구성 요소가 소스 도메인에 과적합된 정보를 기준으로 학습되는 것을 방지하는 Decoupled FineTuning (DeFT) 학습 프레임워크를 제안하였다.

[연구의 의미]

기존 인공지능 모델의 학습에 있어 표준이 되는 패러다임의 한계를 지적하였고, 이를 극복할 수 있는 새로운 학습 패러다임을 제안함으로서 인공지능 모델의 일반화 능력과 관련하여 새로운 연구 방향성과 시사점을 제공한다는 의미를 가진다.

[연구결과의 진행 상태 및 향후 계획]

본 연구는 머신 러닝 분야 최우수 국제학술대회 ICLR 2025에서 포스터로 발표될 예정이다. 향후 제안하는 학습 프레임워크에 대한 심층적인 이론적 분석을 수행하는 연구가 가능하다.

[성과와 관련된 실적]

Jaehyun Pahk, Donghyeon Kwon, Seong Joon Oh, Suha Kwak. “Decoupled Finetuning for Domain Generalizable Semantic Segmentation”. International Conference on Learning Representations (ICLR), 2025

[성과와 관련된 이미지]